AGV Handling Robot Commonly Uses Sensor Principles and Their Advantages and Disadvantages, Application Introduction

Ⅰ. LiDAR

(1) Entdecken Sie, wie LiDAR Hochgeschwindigkeitsziele in Echtzeit erfasst!

LiDAR ist ein Sensorsystem, das Zielinformationen durch Aussenden eines Laserstrahls erfasst. Das Kernprinzip besteht darin, einen Laserstrahl auf das Ziel auszusenden, das reflektierte Signal zu empfangen und die Zielentfernung durch Berechnung der Laser-Umlaufzeit zu bestimmen. Gleichzeitig rotiert das Gerät mit hoher Geschwindigkeit für einen 360-Grad-Scan, erfasst dichte Punktwolkendaten (eine Sammlung von Koordinaten auf der Objektoberfläche) und erstellt in Echtzeit ein digitales 2D-/3D-Modell der Umgebung. Das System kann Position, Geschwindigkeit, Form und viele weitere Parameter des Ziels präzise messen und wird häufig in den Bereichen autonomes Fahren, Kartierung usw. eingesetzt.

1. Punktwolkendaten sind eine Sammlung aller vom LiDAR innerhalb der Scanreichweite erfassten Objektoberflächenpunkte. Jeder Punkt enthält zwei Arten von Kerninformationen:

① Reflexionseigenschaften

Wertebereich: 0-255

Diffus reflektierende Objekte: 0-150 (entsprechend einer Reflektivität von 0%-100%)

Reflektierende Objekte: 151-255 (zB Metall, Glas)

Note: When the object is <2m away from the Mid-360 radar, the reflectivity error is large, and only the total reflection/diffuse reflection type can be judged.

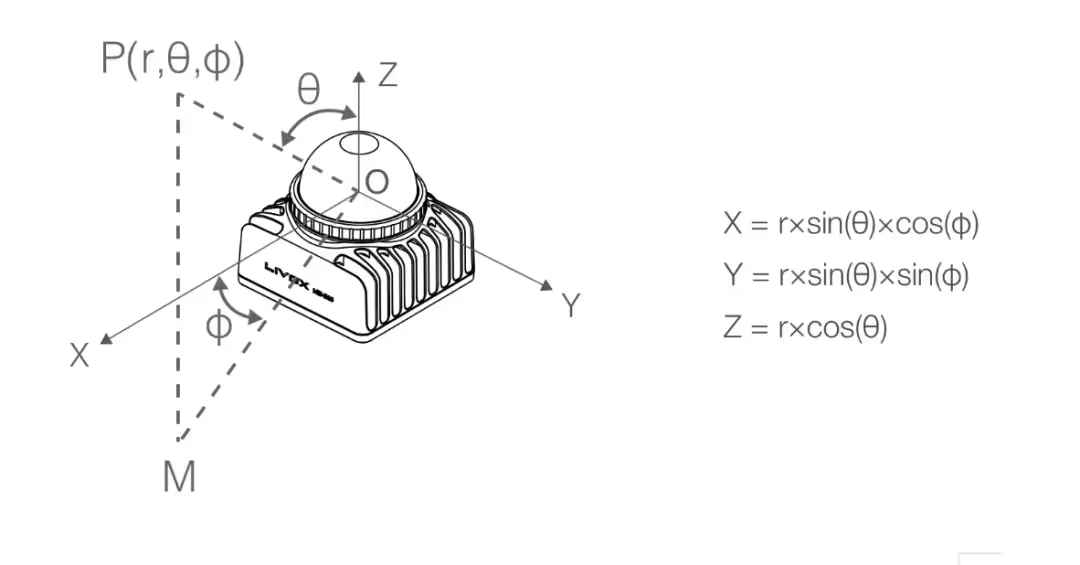

② Räumliche Koordinaten

Art des Koordinatensystems: Kartesische Koordinaten (x,y,z) oder Kugelkoordinaten (r,θ,φ).

Wenn die Erkennung wirksam ist: Geben Sie den wahren Koordinatenwert aus.

Bei ungültiger Erkennung (kein Objekt/Reichweite > 100m überschritten):

Kartesische Koordinaten: (0,0,0)

Kugelkoordinaten: (0,θ,φ) (aktuelle Scanwinkelinformationen beibehalten)

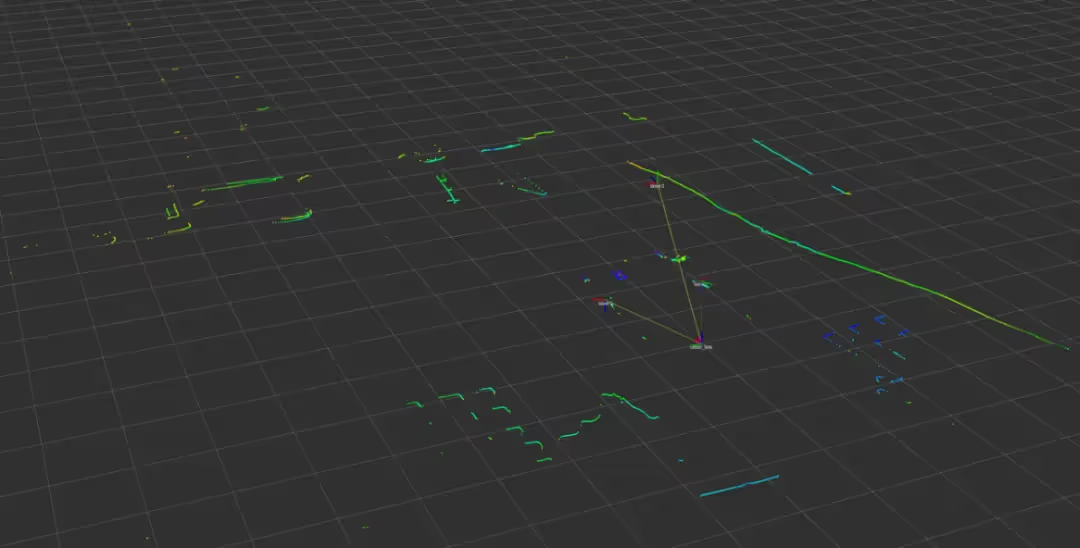

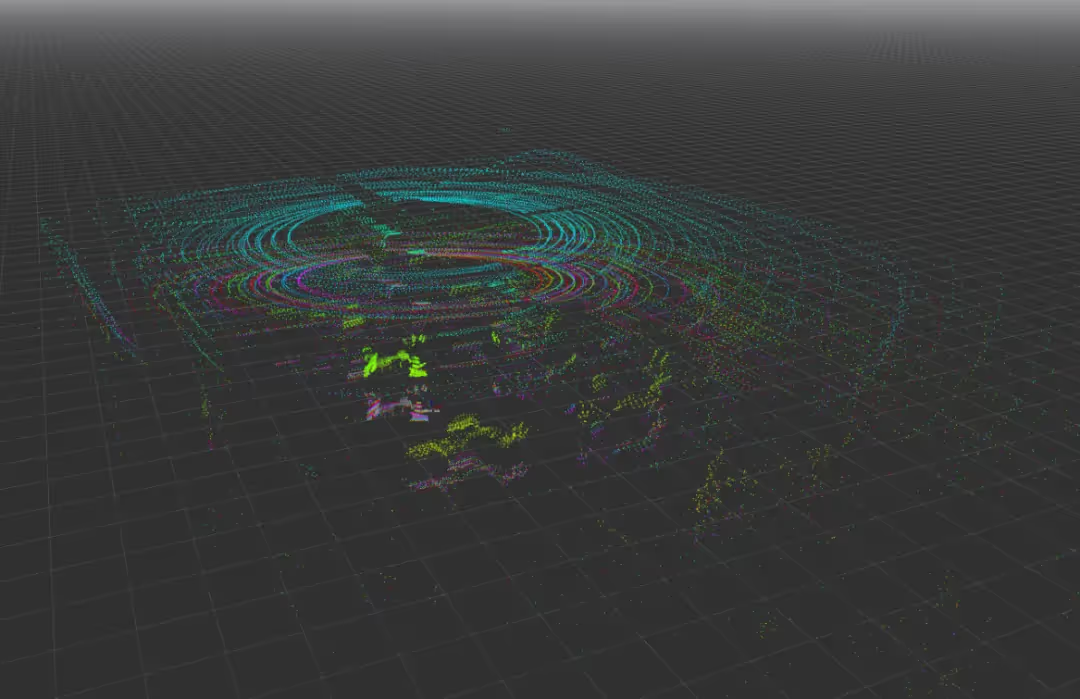

2. LiDAR lässt sich je nach Anzahl der Linien in ein- und mehrzeiliges LiDAR unterteilen. Bei einzeiligem LiDAR sendet der von einer Laserquelle ausgesandte Strahl einzeiliges Radar aus und erstellt eine zweidimensionale planare Scankarte. Bei mehrzeiligem LiDAR werden mehrere Strahlen eines rotierenden Entfernungsmessers gleichzeitig gesendet und empfangen. Derzeit sind 4-, 8-, 16-, 32-, 64- und 128-Punkte-Linien auf dem Markt erhältlich. Mehrzeiliges LiDAR kann die Höhe eines Objekts erkennen und einen 3D-Scan der Umgebung erstellen. Die Abbildung zeigt eine Visualisierung der 2D- und 3D-Punktwolke.

(2) Warum errät die Navigation immer, in welche Richtung Sie fahren möchten?

Lasernavigation ist eine häufig verwendete Navigationsmethode in FTS-Systemen. Dank dieses Navigationsprinzips können FTS frei im Navigationsbereich fahren und präzise orten. Innerhalb des Navigationsbereichs kann die Fahrstrecke des Fahrzeugs jederzeit bedarfsgerecht angepasst werden, was die Flexibilität der FTS voll ausschöpft und die Produktionseffizienz verbessert. Viele Systeme müssen unter den gegebenen Standortbedingungen realisiert werden, was sich besonders für FTS-Systeme mit Lasernavigation eignet.

1. Die Kernprinzipien der Lasernavigation lassen sich in zwei Hauptprinzipien zusammenfassen:

1 Kartenkonstruktion (erste Einsicht in die Umgebung)

Wenn das AGV zum ersten Mal startet, scannt es seine Umgebung von allen Seiten mit LiDAR, ähnlich wie wenn man „einen Raum mit einem Laserpointer scannt“.

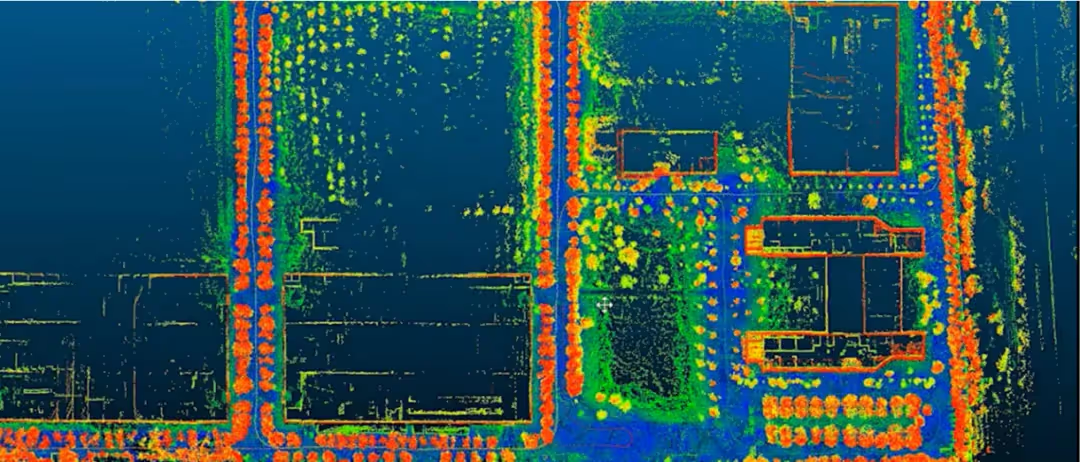

Mithilfe der SLAM-Technologie (Autonomous Localisation + Mapping) erfasst es die Position fester Objekte wie Wände und Geräte, um eine digitale Karte der Umgebung zu erstellen.

②Echtzeit-Positionierung (Positionsbestimmung beim Navigieren)

Während sich das AGV bewegt, scannt der LiDAR kontinuierlich und erfasst in Echtzeit eine Momentaufnahme der Punktwolke der Umgebung.

Die Echtzeitdaten werden mit der gespeicherten Karte verglichen (ähnlich wie beim „Finde den Unterschied“-Spiel) und der Algorithmus berechnet die aktuelle genaue Position und Ausrichtung des AGV.

2. Lasernavigationsfunktionen:

Hochpräzise Positionierung und Navigation, geeignet für Szenen mit strengen Genauigkeitsanforderungen, wie etwa das Stapeln und Ablegen von Waren; gute Anpassungsfähigkeit an die Umgebung, komplexe Szenen haben eine gewisse Kompatibilität, können mit Änderungen der Beleuchtung, leichten Bodenunebenheiten und anderen Störungen umgehen, müssen aber starkes Licht direkt auf dem LiDAR vermeiden, das die Entfernungsgenauigkeit beeinträchtigen kann; keine Beschränkungen durch feste Pfade, im Gegensatz zur magnetischen Führung oder der zweidimensionalen Codenavigation müssen bei der Lasernavigation keine Magnetstreifen oder Etiketten vorab eingebettet werden, der Pfad kann durch die Software frei geändert werden; hohe Intelligenz und Skalierbarkeit, Zusammenarbeit mehrerer Fahrzeuge, durch das zentrale Planungssystem zum Teilen der Karte und der Echtzeit-Positionsinformationen, um kooperative Operationen mehrerer AGVs zu erreichen, wie etwa die Vermeidung von Kreuzungspfaden und die Aufgabenzuweisung.

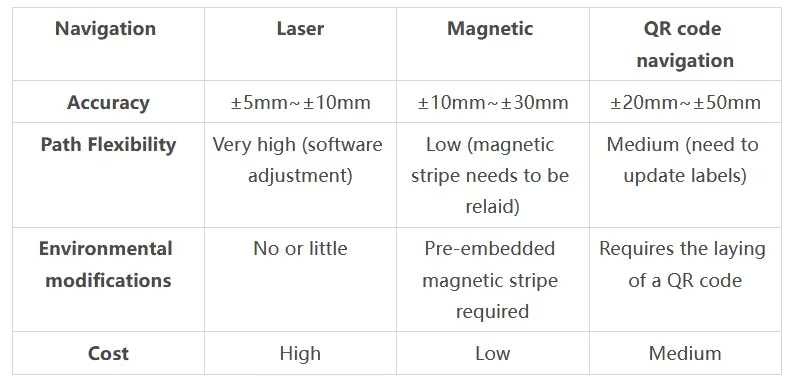

Vergleichen Sie mit anderen Navigationsmethoden, wie in der Tabelle gezeigt:

(3) Wie entsteht der KI-bedingte Reflex, Hindernissen in Sekundenschnelle auszuweichen?

1. Prinzip der Laser-Hindernisvermeidung

Durch Echtzeit-Scannen des Laserradars zur Generierung von Punktwolkendaten aus der Umgebung können die ersten intelligenten Algorithmen benachbarte Punktwolken zu Hindernisclustern aggregieren und zwischen statischen Objekten (unveränderte Position) und dynamischen Objekten (Positionsänderung, vorhersehbare Flugbahn) unterscheiden. Gleichzeitig wird durch gleichzeitiges Scannen mehrerer Radardaten eine einheitliche körperzentrierte Analyse der Umgebung durchgeführt. Alle Körper der Punktwolke außerhalb des Fahrzeugs werden als Hindernisse markiert, und sichere Wege zur Gefahrenvermeidung werden in Echtzeit geplant.

2. Art der Hindernisvermeidung

Einzeiliges LiDAR (z. B. SICK TIM-Serie): kostengünstig, wird zur planaren 2D-Hindernisvermeidung verwendet.

Mehrzeiliges LiDAR (z. B. Livox Mid360, Velodyne VLP-16): 3D-Hindernisvermeidung, erkennt räumliche Höheninformationen, um niedrige oder überhängende Objekte zu vermeiden.

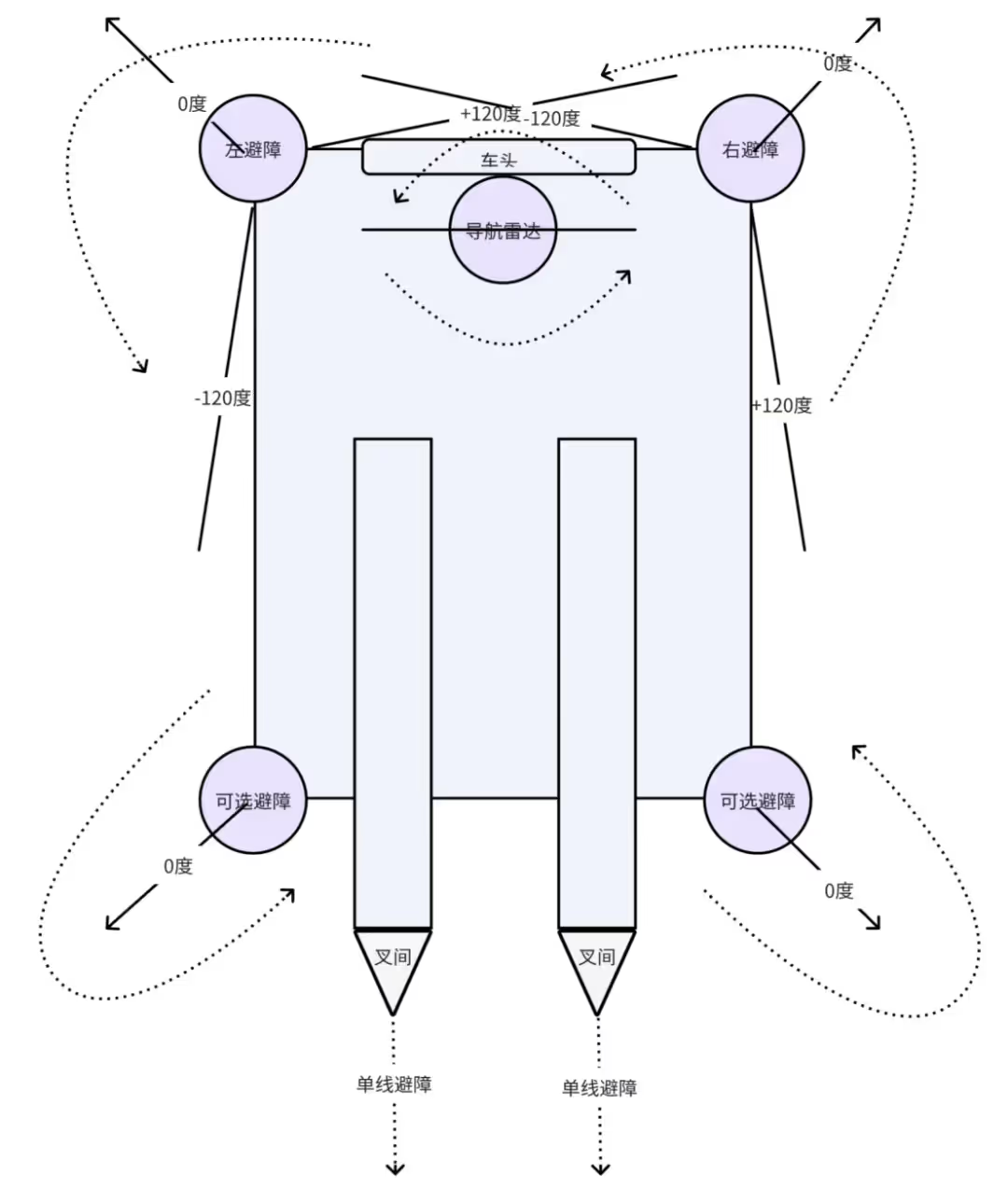

3. Installationsort des Hindernisvermeidungsradars

Dient hauptsächlich der Vermeidung von Hindernissen vorn und hinten, dem seitlichen Schutz beider Karosserieseiten und der umfassenden Überwachung von oben, wie in der Abbildung dargestellt. Front und Heck des Fahrzeugs sind in der Regel an den vier Ecken der Karosserie angebracht, und das Radar ist nach vorne geneigt. Der seitliche Schutz beider Karosserieseiten wird in der Regel durch den Radar-Abtastbereich an den vier Ecken abgedeckt. Die umfassenden Überwachungssysteme von oben nutzen in der Regel gleichzeitig Navigationsradare zur Hindernisvermeidung.

Wenn sich das Radar direkt vor Ihnen bei 0 Grad befindet, beträgt der Bereich zur Abdeckung der Körperkanten plus/minus 135 Grad. Aufgrund von Körperinterferenzen ist es jedoch erforderlich, den körpernahen Teil herauszufiltern. Daher wird der Sichtfeldbereich im Allgemeinen auf plus/minus 120 Grad eingestellt. Zwischen den Gabeln wird im Allgemeinen nur eine einzelne Linie ohne Hindernisvermeidung erkannt.

4. 360-Grad-Hindernisvermeidung im Raum

Bei der Installation von 2D- und 3D-Radaren muss sichergestellt werden, dass der Scanbereich einen gesamten Körper um einen Kreis abdeckt.

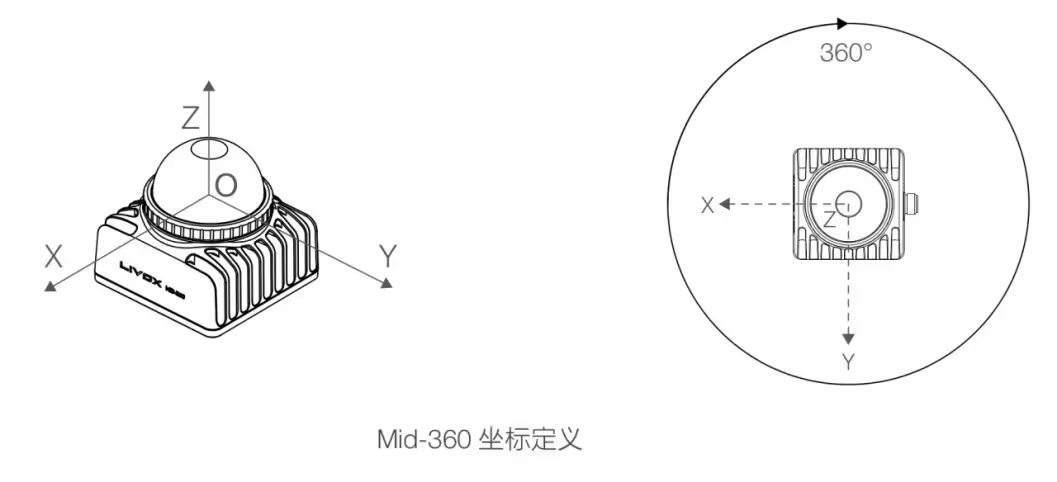

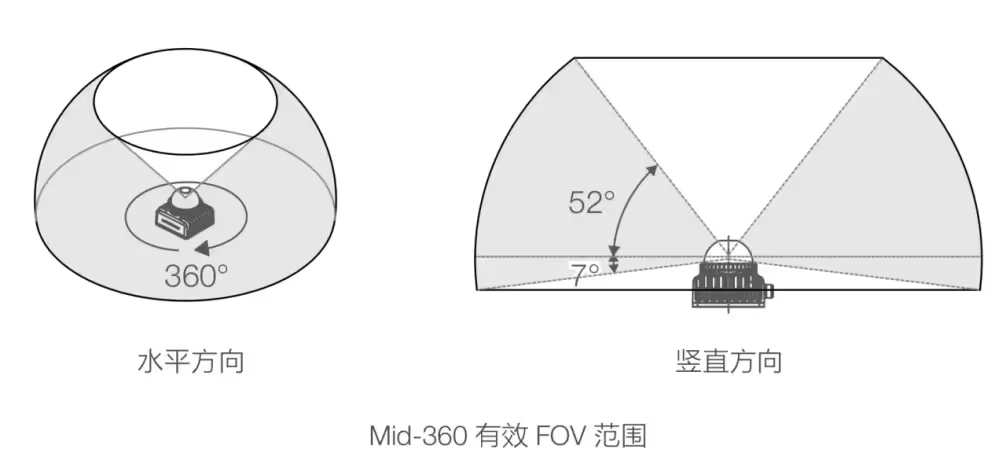

Um beispielsweise ein 3D-Radar bis mid360 zu erhalten, müssen Sie die Definition seiner Koordinaten und die maximale Abdeckung des Scanbereichs kennen, wie in der Abbildung gezeigt.

Das Standardschema ist: Ein 3D-Radar ist vertikal oder nach oben geneigt unter dem vorderen Navigationsradar installiert, ein 3D-Radar ist vertikal oder nach oben geneigt auf beiden Seiten der Karosserie installiert, ein 3D-Radar ist vertikal oder nach oben geneigt unter den Gabeln auf der Rückseite der Karosserie installiert und die optoelektronische IO wird zur Hindernisvermeidung zwischen den Gabeln verwendet.

5. Technische Vorteile und Einschränkungen

Vorteile: Hohe Genauigkeit: Millimetergenaue Entfernungsmessung, deutlich höher als bei Ultraschall oder Infrarot. Störfestigkeit: Unempfindlich gegenüber Umgebungslicht, Staub und elektromagnetischen Feldern (im Vergleich zu Bildsensoren). Schnelle Reaktion: Scanfrequenz üblicherweise 10–50 Hz, geeignet für Hochgeschwindigkeits-AGV (≥ 1,5 m/s).

(4) Lasernavigation in Handhabungsrobotern

1. Übersicht über das Prinzip der Laserwahrnehmung:

Nachdem die Punktwolkendaten durch ein 3D-Radar erfasst wurden, filtert es zunächst die Störinformationen wie Staub und Glasreflexionen heraus und extrahiert dann die wichtigsten Strukturmerkmale wie Regalkanten, Wandecken und Palettengabellöcher mit intelligenten Algorithmen. Schließlich bildet es die Zielobjekte präzise im Koordinatensystem ab, gibt die Positions- und Gesteninformationen aus und erstellt die lokale Umgebungskarte mit Semantik, um die intelligente Wahrnehmung des „Sehens der Objekte und Verstehens der Szene“ zu erreichen. „Intelligente Wahrnehmung“.

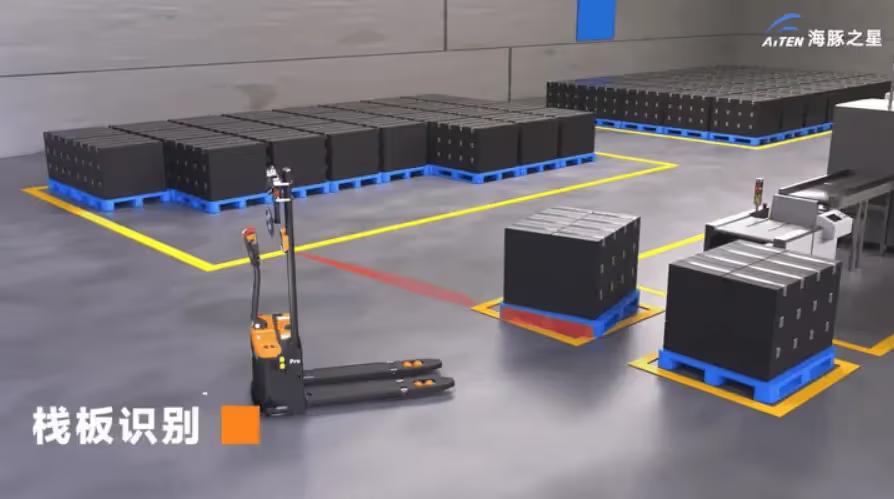

2. Palettenidentifikation und -positionierung

3. Gabelausrichtung

4. Automatisches Stapeln

5. Technische Vorteile und Einschränkungen

Vorteile: Hohe Genauigkeit: Die Laser-Entfernungsmessung erreicht eine Genauigkeit von ±1 mm und erfüllt damit die Anforderungen des industriellen Palettenbetriebs. Unempfindlich gegen Umgebungslicht: Im Vergleich zu Bildverarbeitungslösungen wird der Laser nicht durch Lichtveränderungen beeinflusst. Hohe Echtzeitgenauigkeit: Die Scanfrequenz von 10–50 Hz eignet sich für Hochgeschwindigkeitslogistikszenarien.

Einschränkungen: Hohe Kosten: LiDAR ist deutlich teurer als Ultraschall, insbesondere Mehrlinienradar. Besondere Materialeinflüsse: Schwarze, lichtabsorbierende oder spiegelnde Objekte können die Erkennungszuverlässigkeit beeinträchtigen. Rechenaufwand: Die Echtzeit-Punktwolkenverarbeitung erfordert hohe Rechenleistung (erfordert eingebettete GPU oder dedizierten Prozessor).

Ⅱ. Kamera

(1) Wie ToF Lichtwellen nutzt, um „räumliche Messungen“ im Millimeterbereich zu erreichen

Time-of-Flight (ToF) ist eine der drei gängigen 3D-Bildgebungstechnologien (neben den beiden anderen sind strukturiertes Licht und binokulares Stereosehen). Das Prinzip besteht darin, die Entfernungsinformationen (Tiefe) eines Objekts direkt durch die Emission von Nahinfrarotlicht und die Berechnung der Umlaufzeit des Lichts zu ermitteln. Im Vergleich zu anderen Technologien bietet ToF die Vorteile einer einfachen Berechnung, hoher Entstörungsfestigkeit und Langstreckenmessung. Daher wird es häufig in Rückkameras von Mobiltelefonen (z. B. Huawei/OPPO/Apple), in der industriellen Automatisierung, der AGV-Navigation und beim Robotergreifen eingesetzt.

1. dtof

dToF (Direct Time-of-Flight Ranging) besteht aus drei Kernkomponenten:

① VCSEL: sendet Nanosekunden-Laserpulse aus;

② SPAD (Single Photon Avalanche Diode): erkennt reflektierte Lichtsignale auf der Ebene eines einzelnen Photons;

3 TDC (Time-to-Digital Converter): zeichnet die Hin- und Rücklaufzeit des optischen Impulses genau auf.

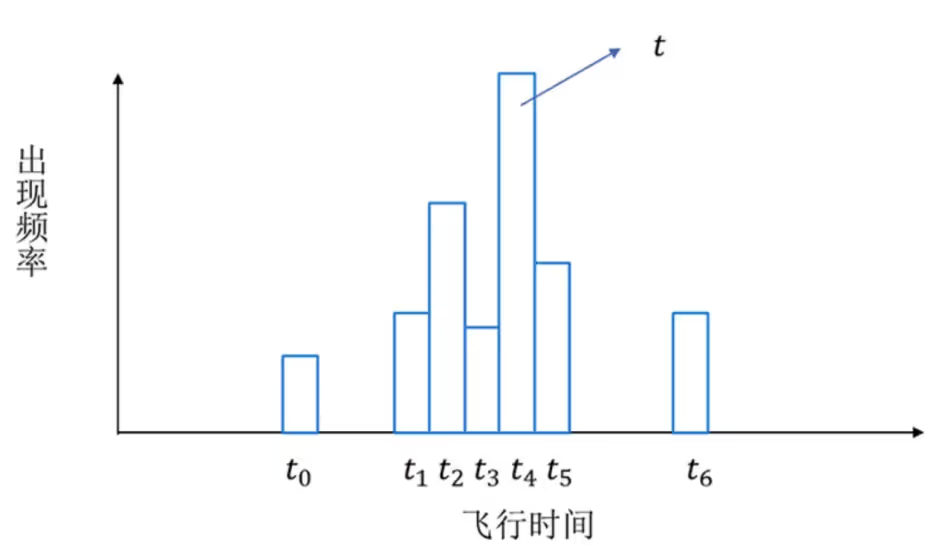

Das Funktionsprinzip ist wie folgt: Senden und Empfangen von N Impulsen in einem einzigen Frame, Aufzeichnen der Laufzeit jedes Mal durch den TDC und Erstellen eines Histogramms. Aus der Zeit t mit der höchsten Frequenz wird die Tiefe berechnet (d = ct/2). Diese Technik verbessert die Entstörungsfähigkeit durch statistische Optimierung erheblich und ermöglicht eine hochpräzise Tiefenmessung.

Obwohl das Prinzip von dToF sehr einfach erscheint, ist es schwierig, eine hohe Genauigkeit zu erreichen. Neben den sehr hohen Genauigkeitsanforderungen für die Taktsynchronisation bestehen auch hohe Anforderungen an die Genauigkeit des Impulssignals. Gewöhnliche Fotodioden können diese Anforderungen kaum erfüllen. Die Kernkomponente von dToF, SPAD, ist aufgrund der Komplexität des Produktionsprozesses und der schwierigen Integration nicht von vielen Herstellern herstellbar. Daher forschen derzeit nur wenige Hersteller an dToF, während immer mehr an iToF forschen und diese fördern.

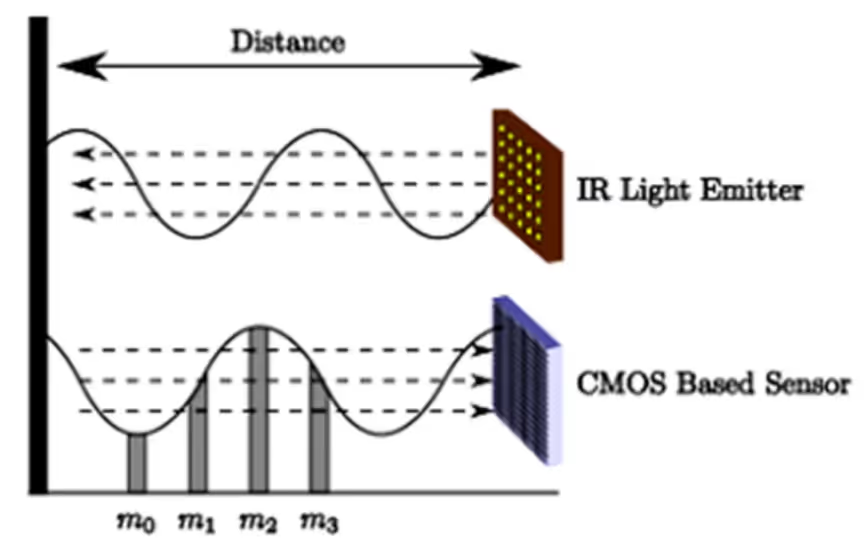

2. davon

Das Konzept von iToF entspricht dToF, und der vollständige Name lautet „indirekte Flugzeit“, was wörtlich übersetzt „indirekte Lichtlaufzeit“ bedeutet. Indirekt bedeutet, dass iToF die Lichtlaufzeit indirekt durch Messung der Phasenverschiebung misst, anstatt die Lichtlaufzeit direkt zu messen. iToF sendet modulierte Infrarotlichtsignale in die Szene. Der Sensor empfängt dann die von den zu messenden Objekten in der Szene reflektierten Lichtsignale und berechnet anschließend die Phasendifferenz zwischen dem gesendeten und dem empfangenen Signal basierend auf der während der Belichtungszeit (Integrationszeit) akkumulierten Ladung, um die Tiefe des Zielobjekts zu ermitteln. Wie in der Abbildung dargestellt.

Die Kernkomponenten des iToF-Moduls bestehen aus einem VCSEL und einem Bildsensor. Der VCSEL emittiert moduliertes Infrarotlicht mit einer bestimmten Frequenz. Der Bildsensor empfängt das reflektierte Licht und führt während der Belichtungszeit (Integration) eine fotoelektrische Umwandlung durch. Nach Abschluss der Belichtung (Integration) werden die Daten ausgelesen und über einen Analog-Digital-Wandler an eine Berechnungseinheit weitergeleitet, die die Phasenverschiebung jedes Pixels berechnet. iToF berechnet die Tiefe mithilfe eines 4-Sampling-Bucket-Algorithmus, der vier Samples mit Phasenverzögerungen von 0°, 90°, 180° und 270° zur Berechnung der Tiefe verwendet. Wie in Abb. dargestellt.

3. Tiefenkartengenerierung

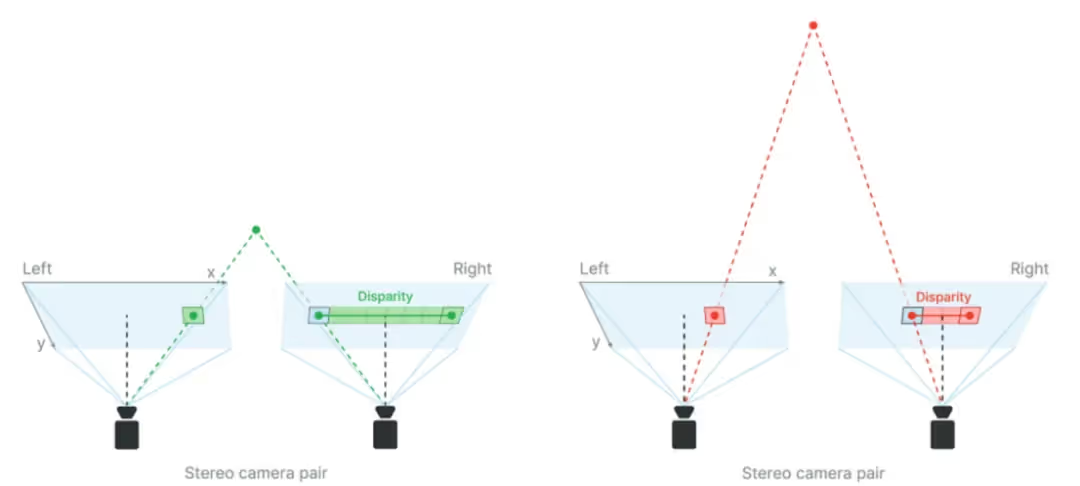

Beim binokularen Stereosehen werden Objekte mit der linken und rechten Kamera synchron aufgenommen und mithilfe der Parallaxe (der Positionsdifferenz von Objekten im Bild) die Tiefe berechnet, ähnlich der Entfernungswahrnehmung des menschlichen Auges. Die ToF-Kamera hingegen zeichnet den Time-of-Flight-Entfernungswert jedes Pixels direkt auf und erzeugt so eine hochauflösende Tiefenkarte (z. B. 640 × 480). In Kombination mit der RGB-Kamera entsteht daraus eine farbenfrohe 3D-Punktwolke. Beides sind Kerntechnologien für die 3D-Umgebungsmodellierung.

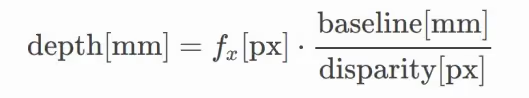

Schematische Berechnungsformel für die Tiefenkarte nach dem Parallaxenprinzip:

Entweder ein größerer Basislinienabstand oder eine größere Brennweite erzeugt größere Tiefen bei gleicher Parallaxe und damit eine höhere Tiefengenauigkeit. Die Brennweite ist der Abstand zwischen Kameraobjektiv und Bildsensor. Je größer die Brennweite, desto enger das Sichtfeld. Um eine Tiefenwahrnehmung über große Entfernungen zu erreichen, können Sie daher den Basislinienabstand vergrößern und/oder das Sichtfeld verkleinern.

(2) Anwendung der ToF-Kamera im AGV-Bereich

1. Hindernisvermeidung und Sicherheitsschutz

Dynamische Hindernisvermeidung: Echtzeiterkennung von Hindernissen innerhalb von 5 m (z. B. Personen, Gabelstapler, Regale), Auslösen einer Verzögerung oder eines Nothalts. Mehrstufige Sicherheitszone (z. B. Warnung außerhalb von 1 m, Nothalt innerhalb von 0,3 m). Niedrige Hinderniserkennung: Erkennung von Paletten, Frachtboxen usw. auf dem Boden, um Kollisionen oder Quetschungen des FTF zu verhindern.

2. Palettenidentifikation und Gabelkommissionierung

Palettenpositionierung: Identifizieren Sie die Gabellochposition der Palette mithilfe einer Tiefenkarte mit einer Genauigkeit von ±3 mm und passen Sie sie an verschiedene Palettentypen (Holz, Kunststoff, Metall) an. Automatische Gabelaufnahme: In Kombination mit der AGV-Bewegungssteuerung wird die Position des Gabelarms angepasst, um ein genaues Einsetzen zu gewährleisten.

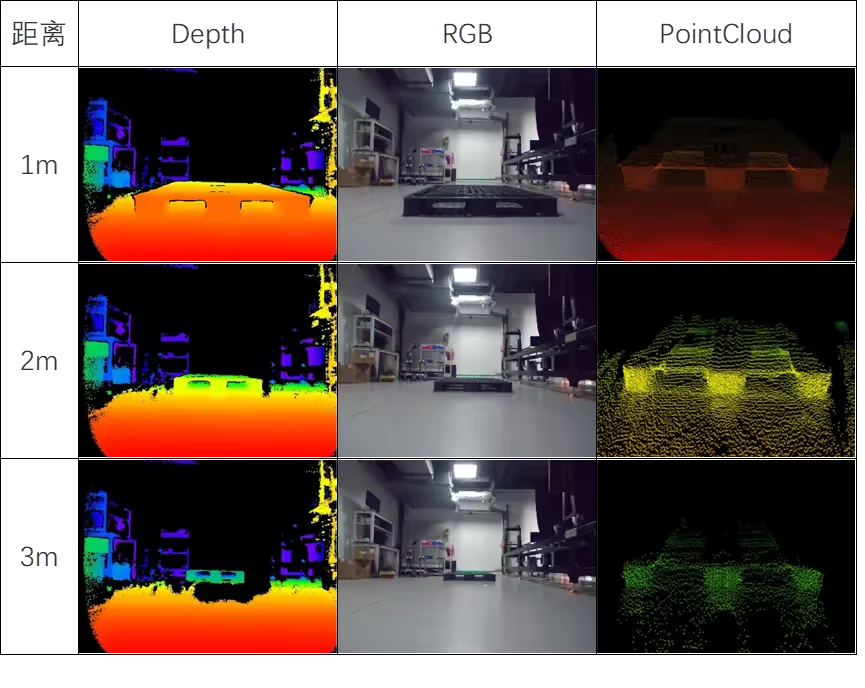

Die Ergebnisse der ToF-Kameraerkennung der schwarzen Palette werden in der folgenden Abbildung dargestellt. Tiefe ist die Tiefenkarte, RGB ist die Farbkarte, PointCloud sind die Punktwolkendaten, die ursprüngliche Punktwolke wird durch den Wahrnehmungsalgorithmus verarbeitet und die endgültige Ausgabe ist die zweidimensionale Position der Palette relativ zur Mitte der Fahrzeugkarosserie.

Stapelerkennung: Messung der Ladungshöhe, um die Stapelstabilität mehrerer Lagen sicherzustellen.

Volumenmessung: Berechnen Sie die Paketgröße (L x B x H) für die Logistiksortierung.

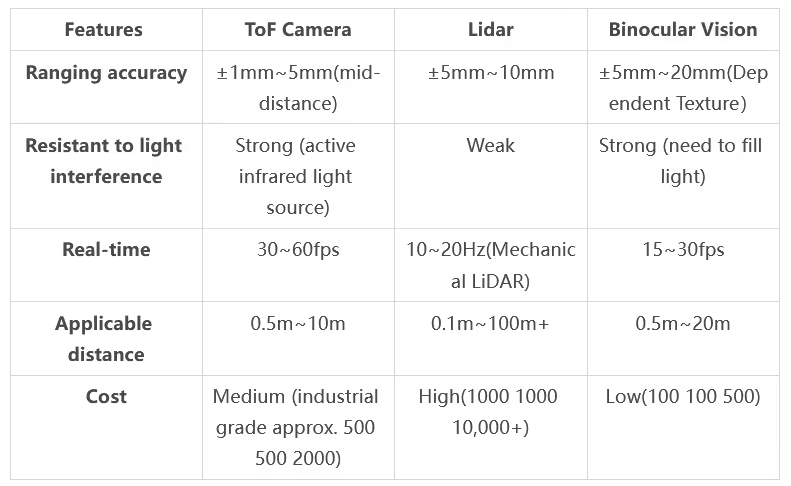

(3) Technische Vorteile von ToF-Kameras

Ⅲ. Andere Wandler

(1) Ultraschallsensor

1. Prinzip: Senden Sie einen Ultraschallimpuls mit 40 kHz bis 200 kHz und empfangen Sie das reflektierte Signal, um die Entfernung zu berechnen.

2. Anwendungen:

AGV-Hindernisvermeidung/Erkennung vor Ort: typischer Strahlwinkel 15°–30° (große Reichweite, geringe Präzision);

Erkennung transparenter Objekte (Glas/Acryl);

Mehrere Geräte müssen Übersprechen verhindern und eine Blindzone (5–20 cm) muss Infrarot-/Laser-komplementär sein.

3. Vorteile:

Resistent gegen Störungen durch Licht, Staub und Nebel, passt sich an die Umgebung komplexer Industriekomplexe an;

Extrem niedrige Kosten (10–100 USD pro Einheit), lange Lebensdauer (> 100.000 Mal);

Berührungslos und ohne Verschleiß.

4. Nachteile:

Geringe Präzision (±1–5 cm, Einfluss von Temperatur und Luftfeuchtigkeit), erfordert Multisensorfusion;

Langsame dynamische Reaktion (50–100 ms), gilt nicht für Hochgeschwindigkeitsszenen (> 1,5 m/s);

Mehrwegereflexionsstörungen, abhängig von Algorithmen (wie RANSAC), Filterrauschen

(2) Trägheitsmesseinheit (IMU)

1. Grundsatz:

Es besteht aus einem Gyroskop (zur Messung der Winkelgeschwindigkeit) und einem Beschleunigungsmesser (zur Messung der linearen Beschleunigung) mit einem teilweise integrierten Magnetometer zur Unterstützung der Kurskalibrierung.

Geben Sie Eulerwinkel durch Lagelösungs- und Filteralgorithmen (z. B. Kalman-Filterung) aus.

2. Anwendungen:

AGV-Navigation: Fusion von Encoderdaten, um Kursdrift auszugleichen und die Positionierungsgenauigkeit zu verbessern;

Dynamische Lageregelung: Echtzeitüberwachung des Gabelneigungs-/Rollwinkels zur Anpassung der Ladungslage;

Infrastrukturfreie Positionierung: autonome Navigation in Tunneln, Innenräumen und anderen GPS-freien Szenarien.

3. Vorteile:

Vollständig autonom, nicht abhängig von externen Signalen (GPS/Reflektoren);

Hochfrequente Updates (bis zu 1 kHz), Echtzeit;

Beständig gegen Licht/Staub/elektromagnetische Störungen (außer Magnetometer).

4. Nachteile:

Kumulierter Fehler: Gyroskopdrift erfordert eine Korrektur der Fusion mehrerer Sensoren (Sicht/Kilometerzähler);

Kalibrierungsabhängigkeit: stationäre Kalibrierung der Nullpunktabweichung bei Inbetriebnahme erforderlich, regelmäßige Wartung;

Anfängliche Ausrichtung: horizontale statische oder bekannte Lageinitialisierung beim Start erforderlich

(3) Seilzuggeber

1. Prinzip: Wegmessung durch Kombination von mechanischer Übertragung und Encoder: Der Zugdraht (Stahldraht/-faser) bewegt sich mit dem Objekt und zieht sich zusammen mit diesem zurück, wodurch der interne Encoder rotiert und die Verschiebung in ein elektrisches Signal umgewandelt wird (Formel: Weg = Encoderauflösung x Anzahl der Impulse x Radumfang).

2. Anwendungen: einschließlich AGV-Gabelpräzisionssteuerung (±1 mm Genauigkeit), Rampenkörpernivellierung und Container-Spreader-Kalibrierung;

3. Vorteile: Ultrahohe Genauigkeit (±0,01 mm), Entstörung (Staub/elektromagnetisch), großer Hub (bis zu 50 m) und flexible Installation;

4. Nachteile: Mechanischer Verschleiß erfordert regelmäßige Wartung, Hochgeschwindigkeitsbewegungen neigen leicht zum Zittern (> 1 m/s) und unterstützen nur unidirektionale Messungen; mehrere Freiheitsgrade erfordern eine Kombination mehrerer Geräte

(4) Optischer Abstandssensor

1. Prinzip: Infrarotlicht aussenden und die reflektierte Intensität erfassen; je geringer die Distanz, desto stärker das reflektierte Signal (kein genauer Distanzwert, nur Schwellenwertbeurteilung).

2. Anwendung: Wird im Allgemeinen zur einfachen Hindernisvermeidung oder zur Erkennung vor Ort verwendet.

3. Vorteile: Sehr niedrige Kosten. Berührungslose Messung: Vermeidung von mechanischem Verschleiß, lange Lebensdauer. Schnelle Reaktion: Erkennung in Millisekunden. Schutz vor elektromagnetischen Störungen: Geeignet für komplexe Industrieumgebungen.

4. Nachteile: Starke Beeinflussung durch Objektfarbe und Oberflächenmaterial. Optische Interferenzen: Starkes Licht, spiegelnde Reflexionen und transparente Objekte beeinträchtigen die Genauigkeit. Reichweitenbegrenzungen: Der allgemeine Grenzwert für die Reichweite ist deutlich niedriger als beim Laser

Schlussfolgerung

In diesem umfassenden Leitfaden wird untersucht, wie hochmoderne Sensortechnologien die Intelligenz und Agilität von AGVs (Automated Guided Vehicles) verbessern.

Zusammen bilden diese Technologien die sensorische Grundlage für intelligente, reaktionsschnelle und hochautomatisierte Materialhandhabungslösungen.

Als Unternehmen im Bereich intelligenter Logistiklösungen hat AiTEN Robotics den Fokus stets auf „Smart Factory“-Szenarien gerichtet, integriert technologische Innovationen tiefgreifend in die Nachfrage der Branche und hat bereits über 200 Kunden aus der Fertigungsindustrie weltweit umfassende Dienstleistungen bereitgestellt: mithilfe der vollständigen Produktmatrix an Handhabungsrobotern zur Abdeckung unterschiedlicher Handhabungsszenarien, eines selbst entwickelten intelligenten Planungssystems auf Branchenniveau zur effizienten Zusammenarbeit mehrerer Geräte und eines Servicesystems über den gesamten Lebenszyklus, das von der Verkaufsvorverkaufsplanung über Bereitstellung und Implementierung bis hin zur Betriebs- und Wartungsoptimierung reicht, haben wir Unternehmen bei der Verwirklichung der intelligenten Transformation der Logistik unterstützt und die Fertigungsindustrie weiterhin bei der digitalen Aufrüstung und Qualitätsentwicklung unterstützt.

_%E7%94%BB%E6%9D%BF%201.avif)