AGV (Automated Guided Vehicle) Multi-Sensor-Fusion für Echtzeit-Hindernisvermeidungstechnologie

I Einführung des AGV-Multisensor-Fusions-Echtzeit-Hindernisvermeidungssystems

1. Einleitung

Sensorfusionstechnologie ist der Schlüssel für Roboter zur flächendeckenden Hindernisvermeidung. Ihr Prinzip orientiert sich an der integrativen Informationsverarbeitung des menschlichen Gehirns: Durch die Koordination mehrerer Sensoren (z. B. LIDAR, Sichtkameras usw.) zur mehrstufigen und mehrdimensionalen Informationsintegration werden die Einschränkungen eines einzelnen Sensors ausgeglichen und letztendlich eine konsistente Umgebungswahrnehmung aufgebaut. Diese Technologie integriert die komplementären Vorteile von Daten aus mehreren Quellen (z. B. präzise Entfernungsmessung und Objekterkennung) und optimiert den Informationsverarbeitungsfluss durch intelligente Algorithmen, sodass AGVs gleichzeitig die Genauigkeit der Hindernisvermeidung und die Anpassungsfähigkeit an die Umgebung in komplexen, dynamischen Umgebungen verbessern können.

2. Verbessern Sie die Erkennungsgenauigkeit

Durch die Integration von LiDAR (genaue Entfernungsmessung, aber Blendung kann leicht stören), visueller Wahrnehmung (Identifizierung des Objekttyps, bei schwachem Licht ist dies eingeschränkt) und Ultraschall (Erkennung des toten Winkels im Nahbereich) sowie anderen Multisensordaten werden Mängel ausgeglichen, um die Genauigkeit der Hindernisidentifizierung zu verbessern.

3. Verbesserte Systemzuverlässigkeit

Durch das redundante Design wird sichergestellt, dass bei Ausfall eines einzelnen Sensors (z. B. LIDAR-Ausfall) andere Sensoren weiterhin die Hindernisvermeidung aufrechterhalten können. In Kombination mit Kalman-Filterung und anderen Algorithmen werden Rauschstörungen herausgefiltert, um die Datenstabilität zu verbessern.

4. Erweiterte Umweltanpassungsfähigkeit

Dynamisches Umschalten der Sensoren ist vorteilhaft, um mit komplexen Szenen umzugehen, wie etwa bei elektromagnetischen Störungen die Wahl von Anti-Jamming-Daten, die Fusion von Ultraschall und LiDAR in Rauchumgebungen und die Aktivierung von Infrarot- und anderen Spezialsensoren für transparente/überhängende Hindernisse.

5. Optimieren Sie die Entscheidungsfindung zur Hindernisvermeidung

Durch Multisensor-Partitionserfassung (z. B. Abgrenzung von Hindernisvermeidungs-/Umleitungszonen vor dem Fahrzeug), Integration von Hindernisentfernung (LIDAR), Art (Sicht) und Näherungsinformationen (Ultraschall), Generierung eines globalen Umgebungsmodells und genaue Planung des optimalen Pfads.

II Multisensor-Fusionsprinzip zur Hindernisvermeidung

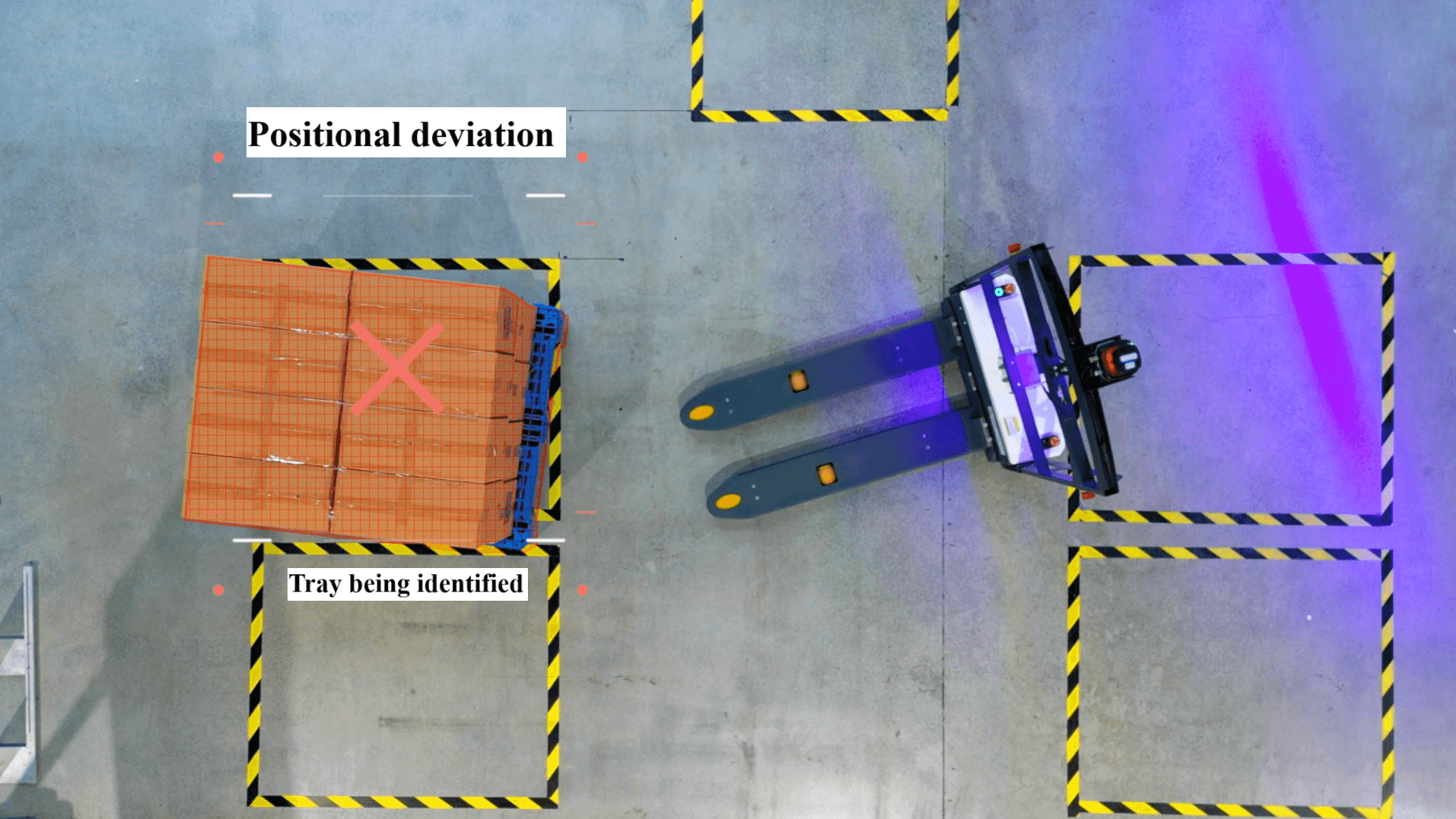

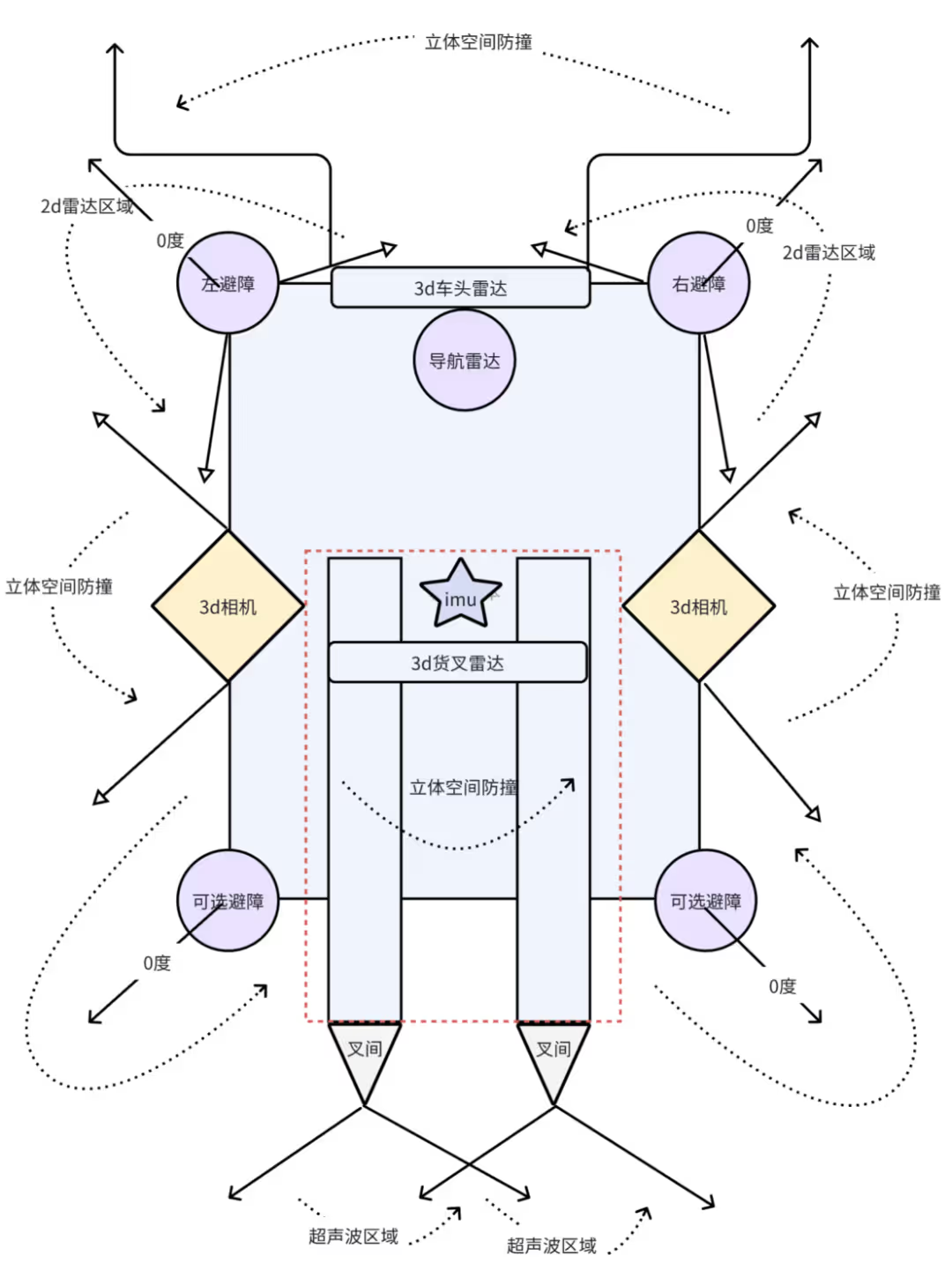

1. Typisches Layout

- Vermeidung von Haupthindernissen vorn: Links und rechts scannen 2D-Laser Hindernisse horizontal, unten ergänzen Ultraschallsensoren die Erkennung niedriger Hindernisse, vorne oben schräger 3D-Laser deckt dreidimensionalen Raum ab.

- Seitlicher Schutz: Schräg montierte Tiefenkameras auf beiden Seiten beseitigen den seitlichen toten Winkel des AGV.

- Vermeidung von Gabelkollisionen: Die Gabel ist mit einer IMU ausgestattet, um die Lage in Echtzeit zu überwachen. In Kombination mit den oberen und unteren 3D-Laserdaten kann die Gabelbahn dynamisch vorhergesagt und die Umgebung geschützt werden.

- Vermeidung von Gabelkollisionen: Doppelte Ultraschallsensoren überwachen die Hindernisse im Sektorbereich auf beiden Seiten des Fahrzeughecks.

2. Fusionsmethoden

- Datenebene: Vereinheitlichen Sie Zeitstempel und Koordinatensysteme mehrerer Sensoren und führen Sie Punktwolkendaten direkt zusammen.

- Funktionsebene : Fusion von LiDAR-Kantenfunktionen mit visuellen SIFT-Funktionen, Deep Learning mit PointNet++ (Punktwolke) und CNN (Bild) oder Generieren von Hinderniswahrscheinlichkeitskarten über EKF.

- Entscheidungsebene: Bayessches Netz gewichtet dynamisch die Zuverlässigkeit jedes Sensors, Ultraschall löst in Notfallszenarien Notbremsungen aus und LiDAR plant Umleitungswege.

3. Umgebungssensorik

- Arbeitsteilung zwischen Ferne und Nähe: Eine 3D-Radarpunktwolke erkennt globale Hindernisse am entfernten Ende und eine Tiefenkamera identifiziert lokale Hindernisse am nahen Ende.

- Hindernisdefinition: einschließlich Personen, Waren, Gabelstaplern und anderen Objekten mit Volumen. Der Kernprozess ist „Erkennung → Verfolgung → Lokalisierung“ (Bestätigung der Existenz → Flugbahnvorhersage → Entfernungsberechnung).

- Semantische Karte: Kennzeichnung von Hinderniskategorien (z. B. Regale, Aufzüge) durch Instanzsegmentierung, Extrahieren von Konturen und Zuordnen dieser zur Karte, um intelligente Entscheidungen zur Hindernisvermeidung zu unterstützen.

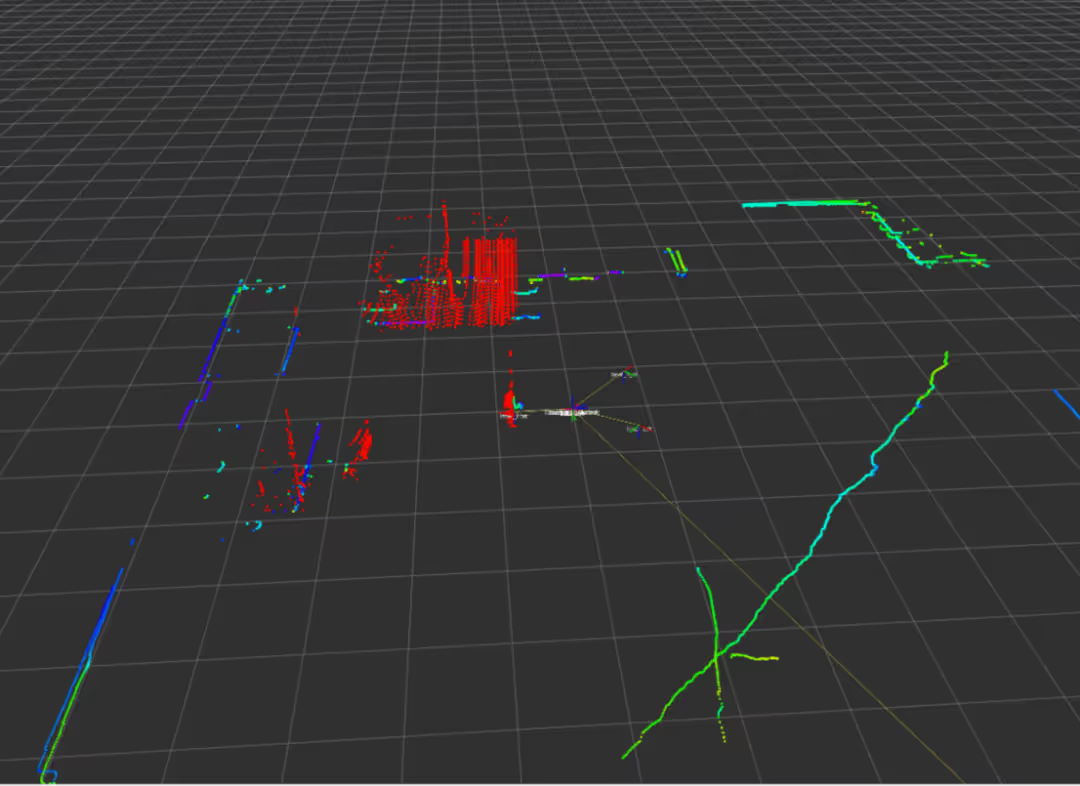

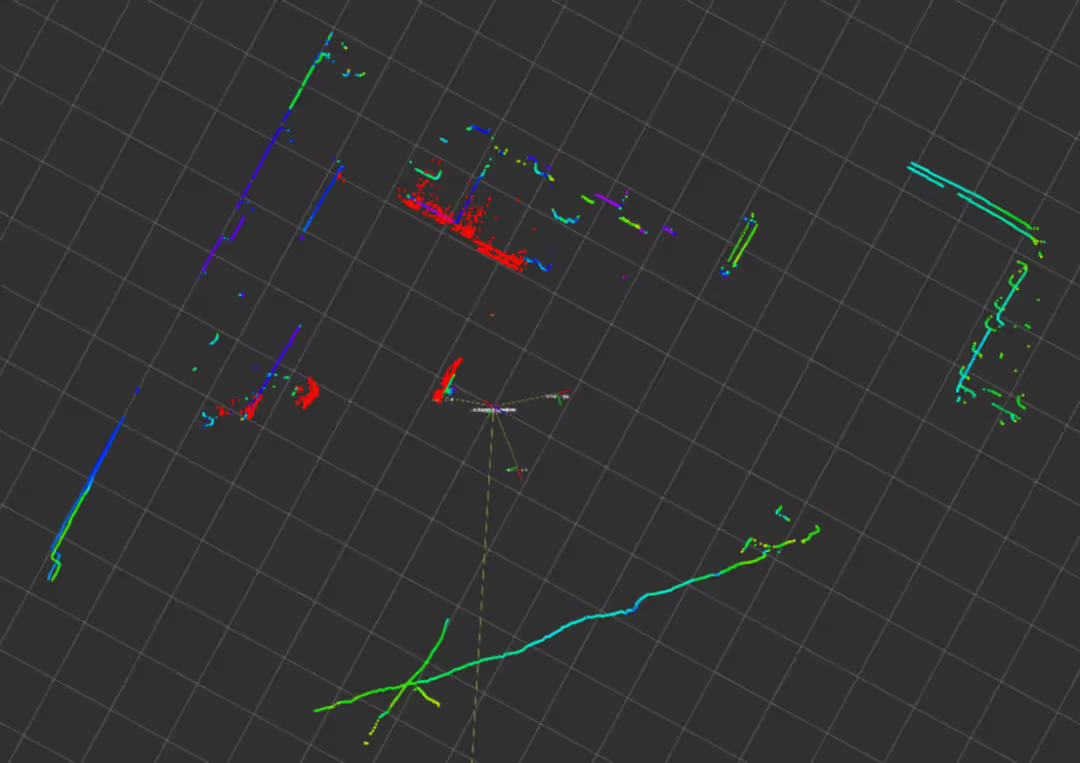

- Globaler Hindernisvermeidungsprozess: Um das Problem großer und verrauschter Punktwolkendaten zu lösen, werden zunächst Filterung und Downsampling durchgeführt. Nach der Segmentierung der Bodenpunktwolke werden die Bodenhinderniscluster mithilfe eines Clustering-Algorithmus segmentiert und Attribute wie Mittelpunkt/Dimension an den umschließenden Rahmen angepasst. In Kombination mit dem Punktwolkenzielerkennungsframework (z. B. PointPillar) werden semantische Annotationen und Tracking durchgeführt und ein Kalman-Filter zum Glätten der Flugbahn erstellt. Gleichzeitig wird eine arithmetische Optimierung durchgeführt, um eine Echtzeitverarbeitung zu gewährleisten. Bei Bewegungsverzerrungen sind Kompensation und Korrektur erforderlich. Echtzeit. Bei Bewegungsverzerrungen ist eine Kompensationskorrektur erforderlich.

4. Echtzeit-Algorithmus zur Hindernisvermeidung

- Lokale Hindernisvermeidung: Die Tiefenkamera deckt den nahezu peripheren Bereich der Karosserie ab, die Gabel-IMU bietet Echtzeit-Feedback zum Lagewinkel und der Bodensensor überwacht räumliche Hindernisse.

- Pfadneuplanung: basierend auf der AGV-Geschwindigkeit (100–200 ms-Zyklus), Abtasten möglicher Flugbahnen durch dynamische Fenstermethode, Vorhersage dynamischer Hindernisbewegungstrends, Optimierungspfad in Echtzeit.

- Unterstützung durch bestärkendes Lernen: In Kombination mit DQN, PPO und anderen Algorithmen wird das AGV trainiert, sich an die komplexe dynamische Szene in der Simulationsumgebung anzupassen, um die Fähigkeit zur autonomen Entscheidungsfindung zu verbessern.

III Herausforderungen und Zukunft der Hindernisvermeidung durch Multisensorfusion

1. Anwendungsszenarien zur AGV-Hindernisvermeidung

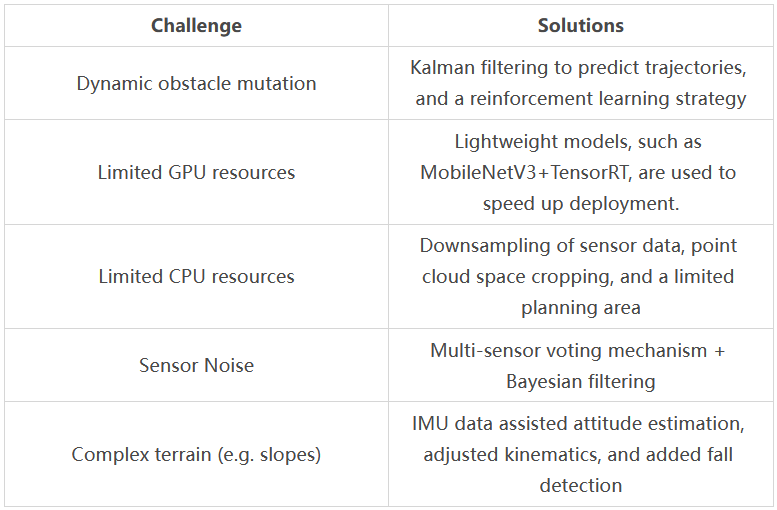

In der Praxis stößt die Hindernisvermeidung bei AGVs häufig auf Schwierigkeiten. Die folgende Liste zeigt Herausforderungen und Lösungen:

2. Zukünftige Richtungen

- Bionische Strategien: Imitieren Sie das Verhalten von Ameisenkolonien/Vogelschwärmen, um dynamische Hindernisbahnen vorherzusagen.

- Neuronale Fusion: End-to-End-Modelle (z. B. PointNet+++Transformer) zur direkten Verarbeitung von LiDAR- und Vision-Daten.

- Gehirnähnliche Architekturen: Impulsneuronale Netzwerke (SNNs) für energiesparende Entscheidungsfindung, LSTM+Aufmerksamkeitsmechanismen zur Vorhersage der Bewegung von Hindernissen über lange Zeitreihen.

- Co-Computing: Cloud-Edge-End-Layered-Processing zur Reduzierung des Rechenaufwands an Bord.

- Simulationsmigration: Domänen-Randomisierung für verbesserte Generalisierung, adaptive Online-Feinabstimmung von Modellen in Echtzeit (z. B. Meta-RL).

- Bevölkerungsintelligenz: Föderiertes Lernen zur Optimierung von Multi-AGV-Pfaden, Spieltheorie zur dynamischen Koordinierung von Vorfahrtsrechten.

- Ziel: Aufbau eines intelligenten Systems zur „Erfassung-Entscheidung-Steuerung“ durch bioinspirierte Algorithmen, domänenübergreifende Zusammenarbeit (V2X/digitaler Zwilling) und energieeffiziente Hardware, um unter Berücksichtigung von Sicherheit, Effizienz und Ethik menschenähnliche Fahrfähigkeiten in komplexen Umgebungen zu realisieren.

Abonnieren Sie AiTEN Robotics für weitere technische Inhalte.

_%E7%94%BB%E6%9D%BF%201.avif)